Google muss deine Website crawlen, bevor sie den Nutzern in den Suchergebnissen angezeigt werden kann. Im Folgenden zeigen wir dir 5 Dinge, die du über den Googlebot wissen solltest.

Der Googlebot überspringt einige URLs

Der Googlebot durchsucht nicht jede URL, die er im Web findet. Je größer eine Website ist, desto größer ist das Risiko, dass einige der URLs nicht gecrawlt und nicht indiziert werden. Warum besucht der Bot nicht einfach jede URL, die er finden kann? Hierfür gibt es zwei Gründe:

Google hat begrenzte Ressourcen. Es gibt viel Spam im Web, daher muss die Plattform Mechanismen entwickeln, um minderwertige Websites zu umgehen. Die Suchmaschine priorisiert dementsprechend beim Crawlen die wichtigen Seiten.

Laut Google wird jeder URL eine Crawling-Priorität zugewiesen. Folglich werden einige URLs nicht gecrawlt, wenn sie die Kriterien nicht erfüllen.

Die Priorität, die einer URL zugewiesen wird, wird durch zwei Faktoren bestimmt:

- Die Popularität einer URL

- Die Wichtigkeit des Crawlings einer bestimmten URL, um den Index aktuell zu halten

Was genau macht eine URL populär?

Google definiert URL-Popularität als eine Kombination aus zwei Faktoren: View Rate und PageRank. Außerdem ist die Antwortgeschwindigkeit Ihres Servers und Ihrer Website ein weiterer Faktor für die Priorität einer Website.

Zusammenfassend lässt sich sagen, dass der Googlebot möglicherweise einige Ihrer URLs beim Crawlen überspringt, wenn die URLs die Priorität, die auf dem PageRank der URL und der Anzahl der Aufrufe basiert, nicht überschreiten. Dies hat einen starken Einfluss auf jede große Website. Wenn eine Seite nicht gecrawlt wird, wird sie nicht indiziert und in den Suchergebnissen angezeigt.

Wie kann meine Website von Google gecrawlt werden?

- Stelle sicher, dass dein Server und deine Website schnell laden

- Überprüfe deine Server-Protokolle. Sie geben dir wertvolle Einblicke darüber, welche Seiten deiner Website von Google gecrawlt werden

Google unterteilt Seiten in neue Ebenen für das erneute Crawling

Die Suchmaschine möchte die Suchergebnisse so aktuell wie möglich halten. Dies ist nur möglich, wenn ein Mechanismus zum erneuten Crawlen bereits indizierter Inhalte existiert. Die Suchmaschine teilt Seiten in Stufen ein, je nachdem, wie oft sie laut Algorithmus neu gecrawlt werden müssen.

Wenn deine Websites also nicht so oft gecrawlt werden, wie du es dir wünscht, sind sie wahrscheinlich in einer Dokumentenebene mit längeren Crawling-Intervallen gelandet. Aber kein Grund zur Panik! Dein Webauftritt muss dort nicht für immer bleiben: Jedes Mal, wenn eine Seite gecrawlt wird, hast du die Chance zu zeigen, dass die Seite es verdient, in Zukunft wieder öfter gecrawlt zu werden.

Wenn die Suchmaschine also eine Seite erkennt, die sich häufiger ändert, könnte sie auf eine neue Ebene aufsteigen. Es reicht jedoch nicht aus, kleine Schönheitselemente zu verändern. Google analysiert sowohl die Qualität als auch die Quantität der Änderungen, die Sie auf den Seiten vornehmen.

Wie werden Websites von Google öfter gecrawlt?

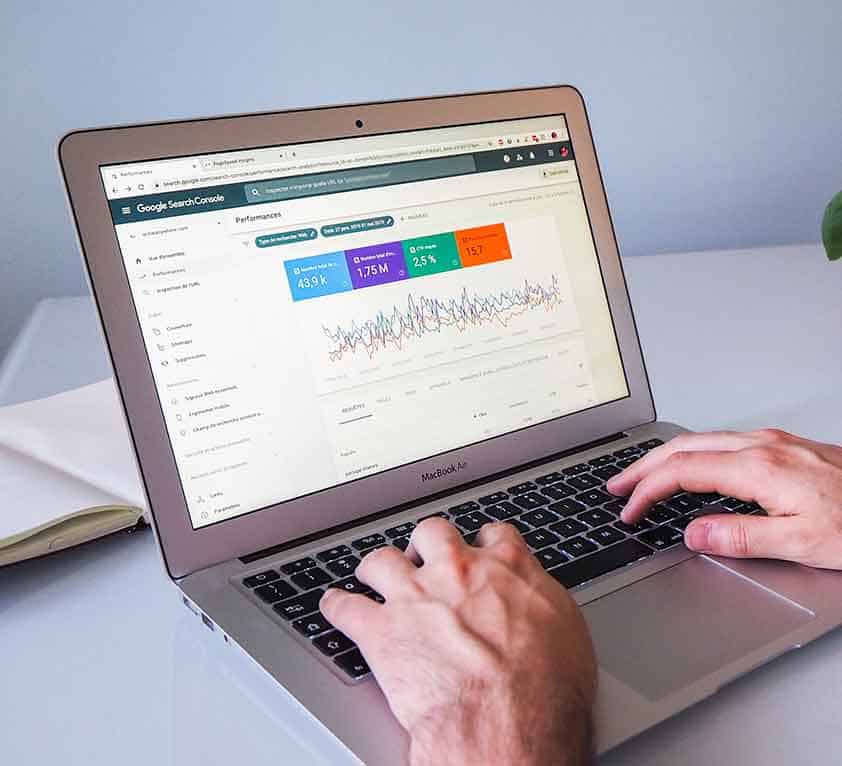

- Nutze Serverprotokolle und die Google Search Console, um herauszufinden, ob deine Websites oft genug gecrawlt werden.

- Verbessere regelmäßig die Qualität deiner Inhalte, wenn du das Crawling-Intervall für deine Seiten verringern möchten. Dadurch wird deine Website öfters von der Suchmaschine durchsucht.

Google indiziert Seiten während eines Crawls nicht neu

Laut Google wird eine Website nicht immer nach jedem Crawl neu indiziert. Die Suchmaschine indiziert Inhalte nicht neu, wenn der Inhalt nur geringfügig geändert wurde.

Wie wird meine Website von Google neu indiziert?

Wenn du eine Website mit News und regelmäßig aktualisierten Beiträgen hast, prüfe, ob Google diese schnell genug indexiert. Wenn nicht, kannst du sicher sein, dass “Google News” ungenutztes Potenzial hat.

Click-Through-Rate und interne Links

Die Klickrate beeinflusst, wie oft eine URL gecrawlt wird. Laut der Suchmaschine spielt auch der PageRank eine Rolle. Auch aus diesem Grund solltest du darauf achten, dass du die verschiedenen Inhalte deiner Website mit einer guten internen Linkstruktur verknüpfst.

Was kannst du tun, um interne Links und die Klickrate zu verbessern?

- Können Google und die Nutzer leicht auf die wichtigsten Bereiche deiner Website zugreifen?

- Können alle wichtigen URLs erreicht werden? Es reicht nicht aus, wenn alle Ihre URLs nur über die Sitemap erreichbar sind.

Nicht alle Backlinks sind gut für Ihr Ranking

Google ist sich bewusst, dass einige Links auf einer Seite prominenter platziert sind als andere. Die Suchmaschine kann diese Links deshalb unterschiedlich behandeln. Daher analysiert die Suchmaschine Links anhand ihrer unterschiedlichen Eigenschaften, wie z. B. der Schriftgröße oder der Linkplatzierung. Es scheint sogar, dass die Suchmaschine Regeln erstellt, um Links auf Seitenebene zu bewerten.

Zusammengefasst solltest du dir Folgendes merken:

- Google vergibt Prioritäten für jede gecrawlte Seite.

- Je schneller die Website, desto schneller kann Google sie crawlen.

- Die Suchmaschine wird nicht jede URL crawlen und indizieren. Nur URLs, deren zugewiesene Priorität über dem Schwellenwert liegt, werden gecrawlt.

- Links werden je nach Eigenschaften und Platzierung unterschiedlich behandelt.

- Google indiziert eine Seite nicht nach jedem Crawl neu. Es hängt davon ab, wie stark die vorgenommenen Änderungen sind.

Quelle: Google